Ollama: Guía completa para entender y usar modelos locales de IA

La Inteligencia Artificial (IA) sigue revolucionando nuestra forma de trabajar, aprender y crear contenido.

Entre las diversas herramientas disponibles, Ollama ha surgido como una excelente opción para ejecutar modelos de lenguaje de manera sencilla y local, ofreciendo privacidad, flexibilidad y alto rendimiento.

¿Qué es Ollama?

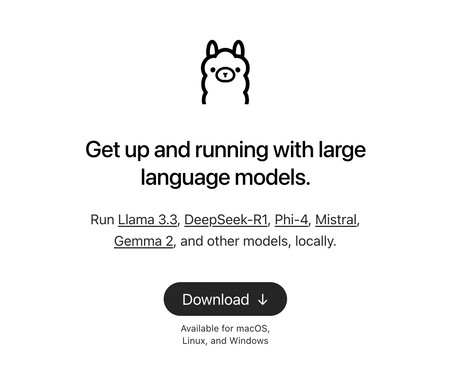

Ollama es una herramienta open-source diseñada para ejecutar modelos de lenguaje (LLMs, por sus siglas en inglés) localmente en tu ordenador.

Ollama facilita el uso de estos modelos, permitiendo interactuar directamente con poderosas inteligencias artificiales como Llama 2, Mistral o Gemma sin depender de servicios en la nube.

Ventajas de utilizar Ollama

– Privacidad: Al ejecutar modelos localmente, tus datos nunca abandonan tu equipo.

– Velocidad: Mayor rapidez al eliminar la latencia de conexión a la nube.

– Personalización: Posibilidad de usar modelos personalizados según necesidades específicas.

– Reducción de costes: Evita gastos recurrentes en servicios cloud.

Aplicaciones prácticas de Ollama

Ollama es especialmente útil en múltiples escenarios:

– Creación de contenidos: Genera textos, ideas o resúmenes sin conexión.

– Soporte y atención al cliente: Automatiza respuestas comunes manteniendo privacidad.

– Investigación y desarrollo: Prueba rápidamente modelos personalizados y nuevas ideas.

– Educación: Usa modelos interactivos para enseñar conceptos complejos de forma intuitiva.

Consideraciones técnicas

Aunque Ollama es potente, requiere de recursos suficientes, especialmente memoria RAM y GPU, para ejecutar modelos grandes con fluidez. Verifica siempre los requisitos del modelo que deseas utilizar.